Di recente ETSI (European Telecommunications Standards Institute) ha condotto il primo studio al mondo sui rischi derivanti dall’uso dei deepfake generati dall’intelligenza artificiale (IA).

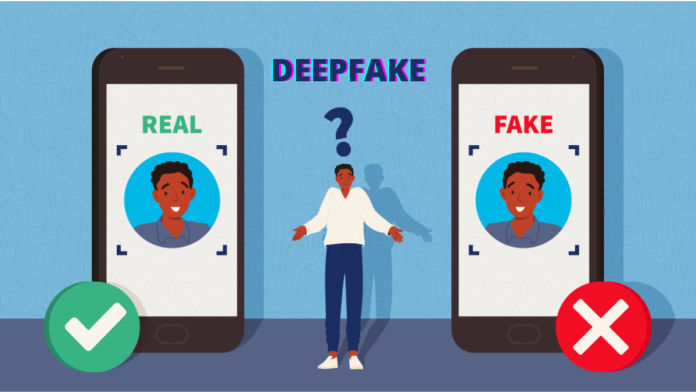

Ormai i software IA sono in grado di creare i cosiddetti deepfake: foto, video o audio totalmente falsi, creati a partire da dati multimediali forniti dal web, che risultano iperrealistici.

Lo studio

ETSI ha studiato il fenomeno dei deepfake per poi fornire un report con lo scopo di sensibilizzare gli utenti e metterli in guardia dai potenziali pericoli legati ad una gestione poco prudente dei propri dati personali sul web.

Scott Cadzow, l’esperto in AI Security che ha curato il rapporto, sostiene infatti che “le tecniche di IA consentono manipolazioni automatizzate che in precedenza richiedevano una notevole quantità di lavoro manuale e, in casi estremi, possono persino creare dati multimediali falsi da zero”.

La contromisure da adottare

Il problema dei deepfake è molto complesso e non esiste, secondo ETSI, un rimedio universale in grado di eliminarlo del tutto. Si possono però prendere alcune contromisure utili a proteggersi.

Il primo passo è educare gli utenti divulgando tutto quello che c’è da sapere.

Per mettersi ai ripari si potrebbero addestrare dei software IA a riconoscere i contenuti manipolati e infine contrassegnarli come falsi così che sia evidente a tutti.

Ancora, si potrebbe ricorrere ad una normativa specifica che regolamenti e condanni il sistema.

Articolo di F.M.